Model DeepSeek-OCR Memproses Teks Kompleks Menggunakan Jumlah Token 20 Kali Ganda Lebih Kecil

Effi Saharudin

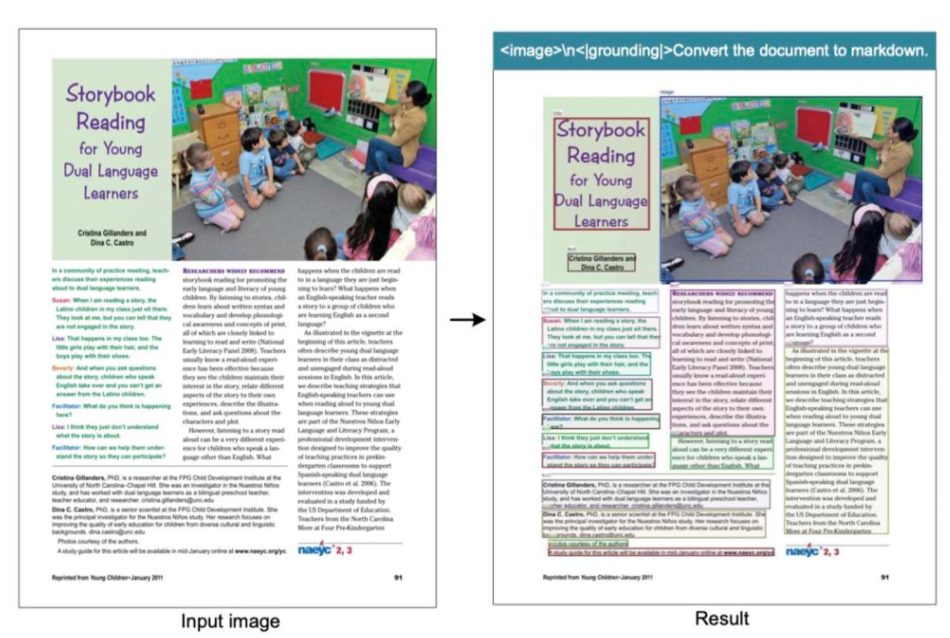

Minggu ini Alibaba Cloud mengumumkan pengoptimasian latihan kecerdasan buatan (AI) yang mengurangkan penggunaan GPU NVIDIA sehingga 82%. Hari ini pula DeepSeek melancarkan model DeepSeek-OCR yang berkemampuan memproses jumlah teks yang besar dan kompleks tetapi menggunakan token sehingga 20 kali ganda lebih kecil berbanding sebelum ini.

Dengan DeepSeek-OCR latihan model bahasa raya (LLM) yang lebih besar boleh dilakukan tanpa peningkatan kos perkomputeran pusat data AI. Ini dilakukan menerusi pemprosesan data dalam bentuk imej dan bukannya teks. Penyelidik mendapati satu dokumen dalam bentuk gambar yang dimampatkan, jumlah token yang diperlukan untuk memprosesnya adalah lebih kecil berbanding dokumen yang sama dalam bentuk teks.

DeepSeek-OCR bukan sahaja boleh membaca teks tetapi juga carta, persamaan kimia, angka geometri mudah dan imej semula jadi. Dalam kegunaan dunia sebenar, satu kad grafik A100-40G boleh menyokong penjanaan lebih daripada 200,000 halaman data latihan untuk model bahasa raya (LLM) dan model bahasa visual (LVM) setiap hari.

Menerusi pengumuman hari ini, ia menunjukkan China mempunyai paradigma berbeza dalam melakukan latihan model AI. Di Barat penggunaan cip AI yang lebih berkuasa dan pantas diperlukan sementara China yang kini dihalang akses kepada cip yang lebih terkini, sistem latihan yang lebih cekap dibangunkan untuk melatih model menggunakan cip AI yang kurang berkuasa.

DeepSeek-OCR dilancarkan secara terbuka dengan ia boleh diakses menerusi Github dan HuggngFace hari ini.

Komen

Sila log masuk untuk menghantar komen.